Spis treści

Jak zbudowany jest procesor?

Procesor to zaawansowany układ, który w dużej mierze oparty jest na monokryształu krzemu. Jego kluczowa rola polega na przetwarzaniu informacji. W tej konstrukcji wykorzystywane są cienkie krzemowe wafle, na których tworzone są sieci tranzystorów odpowiedzialnych za wykonywanie operacji logicznych.

W obwodach procesora znajdziemy takie metale, jak miedź i aluminium, które łączą różne elementy mikroobwodów. Cały proces produkcji rozpoczyna się od czystego krzemu. Następnie poddawany jest litografii, czyli procesowi, w którym na jego powierzchni powstają precyzyjne wzory. Dzięki tej technologii mikroobwody zyskują odpowiednią wielkość i precyzję, co jest niezwykle istotne dla efektywnego działania procesora.

Kolejnym etapem jest trawienie chemiczne, które formuje ostateczne kształty tranzystorów oraz ich połączeń. Nowoczesne technologie znacząco poprawiają właściwości przewodzące procesora, co przekłada się na jego wydajność oraz szybkość działania. W dzisiejszych czasach procesory to złożone układy scalone, które mogą zawierać miliardy tranzystorów, umożliwiając realizację skomplikowanych obliczeń w bardzo krótkim czasie.

Co to jest CPU i jaką pełni rolę?

Centralna jednostka obliczeniowa, znana jako CPU, stanowi serce każdego komputera i smartfona. To ona odpowiada za większość zadań związanych z obliczeniami. Procesor działa, wydobywając dane z pamięci operacyjnej, interpretując je, a następnie wykonując określone polecenia.

Swoją funkcjonalność opiera na złożonej architekturze, która obejmuje:

- jednostkę arytmetyczną,

- kontroler,

- rejestry do przechowywania informacji.

Zrozumienie wydajności procesora wymaga przyjrzenia się, jak szybko i efektywnie realizuje on polecenia. Kluczowe aspekty to:

- częstotliwość taktowania,

- liczba rdzeni,

- technologia hyper-threading.

Współczesne procesory wykorzystują technologię hyper-threading, co znacznie zwiększa ich moc obliczeniową. Na przykład, dzisiejsze modele osiągają oszałamiające parametry, co umożliwia im błyskawiczne przeprowadzanie skomplikowanych operacji. Dodatkowo, dzięki nowatorskim metodom produkcji, ich możliwości ciągle się rozwijają.

Co to jest architektura procesora?

Architektura procesora odnosi się do struktury i organizacji jego komponentów, definiując sposób przetwarzania danych oraz wykonywania instrukcji. Wyróżniamy kilka typów architektur, takich jak:

- CISC (Complex Instruction Set Computing),

- RISC (Reduced Instruction Set Computing),

- VLIW (Very Long Instruction Word).

Każdy z tych modeli przyjmuje odmienny sposób osiągania wydajności i złożoności wykonania poleceń. Różnice między nimi dotyczą m.in. liczby dostępnych rozkazów oraz metod ich przetwarzania. Przykładowo, architektura CISC umożliwia realizację bardziej złożonych instrukcji w pojedynczym cyklu zegarowym. Natomiast RISC koncentruje się na uproszczonym zestawie instrukcji, co przyspiesza ich przetwarzanie. Z kolei VLIW stawia na równoległe wykonywanie wielu rozkazów, co znacząco zwiększa efektywność jednostek arytmetycznych.

Architektura procesora wpływa również na mikroarchitekturę, która definiuje, jak wewnętrzne komponenty procesora – takie jak jednostka arytmetyczna, jednostka sterująca i rejestry – współdziałają ze sobą. Odpowiednie zaprojektowanie architektury jest niezwykle istotne, ponieważ pozwala na osiągnięcie optymalnej wydajności operacyjnej oraz efektywności energetycznej. Warto zauważyć, że inżynierowie wciąż pracują nad poprawą tych elementów, aby sprostać rosnącym wymaganiom technologicznym w różnych obszarach, od komputerów stacjonarnych po urządzenia mobilne.

Co to jest mikroarchitektura i jakie ma znaczenie dla procesora?

Mikroarchitektura to precyzyjna realizacja projektu procesora, która odgrywa kluczową rolę w zakresie:

- wydajności,

- oszczędności energii,

- możliwości rozbudowy systemu.

To właśnie ona definiuje sposób działania wewnętrznych komponentów procesora, takich jak:

- wykonanie instrukcji,

- zarządzanie pamięcią podręczną,

- sposób, w jaki wykorzystywane są jednostki wykonawcze do przetwarzania danych.

Na przykład, mikroarchitektura Intel Skylake wprowadza znaczące poprawki w efektywności energetycznej oraz ogólnej wydajności w porównaniu do swoich poprzedników dzięki zwiększonej liczbie rdzeni i zastosowaniu technologii hyper-threading. Z kolei, mikroarchitektura AMD Zen 3 oferuje znaczące ulepszenia, które umożliwiają lepsze osiągi przy mniejszym poborze energii. Te nowatorskie rozwiązania pozwalają producentom procesorów na zwiększenie mocy obliczeniowej, co staje się kluczowe w obliczu wzrastających wymagań nowoczesnych aplikacji. Dobrze przemyślana mikroarchitektura sprzyja efektywnemu wykorzystaniu zasobów procesora, co w rezultacie wpływa na jego dłuższą żywotność.

Jakie elementy składają się na strukturę procesora?

Struktura procesora składa się z kilku kluczowych elementów, które współpracują ze sobą, by zapewnić sprawne działanie. Ważnymi składnikami są:

- zespół rejestrów – szybka pamięć wewnętrzna, w której tymczasowo przechowywane są dane oraz wyniki obliczeń, co znacząco przyspiesza przetwarzanie informacji,

- jednostka arytmetyczno-logiczna (ALU) – odpowiedzialna za realizację podstawowych operacji, takich jak dodawanie, odejmowanie czy mnożenie, a także za przeprowadzanie operacji logicznych, jak AND lub OR, co czyni ją sercem wszelkich obliczeń w systemie,

- układ sterujący – pełni rolę koordynatora, zarządzając instrukcjami oraz zapewniając odpowiednią kolejność przetwarzania danych. Dodatkowo odpowiada za przepływ energii oraz kontrolowanie połączeń między różnymi komponentami.

Modułowa budowa procesora umożliwia optymalne wykorzystanie tych elementów, co przekłada się na wyższą wydajność i lepszą efektywność energetyczną. Współczesne procesory często zawierają także dodatkowe moduły, takie jak kontrolery pamięci czy magistrale, co zwiększa ich możliwości oraz funkcjonalność.

Jakie elementy składają się na rdzeń procesora?

Rdzeń procesora składa się z istotnych komponentów, które wspólnie działają na rzecz osiągnięcia wysokiej efektywności i mocy obliczeniowej. Wymieniając najważniejsze z nich, warto zwrócić uwagę na kilka kluczowych elementów:

- jednostki wykonawcze – odpowiedzialne za przeprowadzanie obliczeń oraz operacji logicznych. W nowoczesnych procesorach można spotkać różnorodne typy jednostek, takie jak jednostki arytmetyczno-logiczne (ALU) czy też te, które obsługują specjalne instrukcje,

- pamięć podręczna (cache) – to szybka pamięć, która gromadzi często wykorzystywane dane i instrukcje, co przyspiesza dostęp do informacji w porównaniu do pamięci RAM. Jest ona zorganizowana w różne poziomy (L1, L2, L3), z których L1 zapewnia najszybszy dostęp, znajdując się najbliżej jednostek wykonawczych,

- układ sterujący – którego rolą jest koordynacja obliczeń oraz ustalanie kolejności wykonywania instrukcji. Monitoruje on przepływ danych w rdzeniu, synchronizując pracę wszystkich komponentów,

- rejestry – drobne, ale niezwykle szybkie jednostki pamięci, które przechowują tymczasowe wyniki obliczeń oraz dane do dalszej obróbki. Ich liczba znacząco wpływa na efektywność operacyjną rdzenia,

- architektura wielordzeniowa – pozwala poszczególnym rdzeniom na samodzielną pracę, co umożliwia równoległe przetwarzanie danych, co z kolei znacząco zwiększa moc obliczeniową całego procesora,

- innowacje w dziedzinie częstotliwości taktowania – mogą osiągać nawet 5 GHz, co przekłada się na istotny wzrost wydajności w wymagających zadaniach obliczeniowych.

Jak działa zespół rejestrów w procesorze?

Zespół rejestrów w procesorze pełni niezwykle ważną rolę w szybkim przetwarzaniu informacji oraz realizacji obliczeń. To niewielkie, aczkolwiek bardzo szybkie jednostki pamięci, które przechowują dane i wyniki obliczeń. Dzięki nim operacje mogą odbywać się znacznie szybciej.

Bezpośredni dostęp do danych z rejestrów pozwala na ominięcie pamięci głównej, co z kolei znacząco podnosi wydajność procesora. W typowej architekturze procesora spotykamy różne rodzaje rejestrów, w tym:

- rejestry danych – odpowiedzialne za przechowywanie wartości niezbędnych w obliczeniach,

- rejestry adresowe – wskazujące miejsce lokalizacji danych w pamięci,

- rejestry stanu – informujące o aktualnym stanie operacji.

Taki zespół rejestrów znacznie skraca czas realizacji operacji arytmetycznych oraz logicznych, ponieważ procesor może pracować bezpośrednio na danych znajdujących się w rejestrach, co jest zdecydowanie szybsze od dostępu do pamięci głównej. Można zatem postrzegać zespół rejestrów jako formę pamięci podręcznej, która wspiera procesor w skomplikowanych obliczeniach, przyspieszając wykonywanie kodu.

Wydajność rejestrów jest szczególnie zauważalna w aplikacjach wymagających intensywnej mocy obliczeniowej, takich jak gry komputerowe czy oprogramowanie do modelowania 3D. Dlatego optymalizacja ich działania jest niezwykle istotna dla zwiększenia efektywności całego systemu komputerowego.

Jak funkcjonuje układ sterujący procesora?

Układ sterujący procesora odgrywa fundamentalną rolę w efektywnym funkcjonowaniu systemów obliczeniowych. Jego głównym zadaniem jest koordynowanie przepływu danych pomiędzy różnymi elementami, takimi jak:

- jednostka arytmetyczno-logiczna,

- rejestry.

Poza tym, odpowiedzialny jest za dekodowanie instrukcji pobranych z pamięci, a jego działanie opiera się na hierarchii zależnych rozkazów, które muszą być przetwarzane w odpowiedniej kolejności. Interpretuje i realizuje polecenia, korzystając z mikroprogramowania, co umożliwia elastyczne zarządzanie procesami obliczeniowymi. Obejmuje to zarówno proste operacje, jak:

- dodawanie,

- porównywanie,

- jak i bardziej skomplikowane działania logiczne.

Jego architektura przyczynia się do wydajnej wielozadaniowości, a także efektywnego dostępu do pamięci. Dzięki temu staje się nieodłącznym elementem nowoczesnych procesorów. Nie bez powodu szybkość i precyzja obliczeń są kluczowe w kontekście wydajności komputerów. Układ sterujący stanowi zatem fundament, na którym opiera się funkcjonowanie procesora, co pozwala na realizację skomplikowanych zadań w krótkim czasie.

Jakie są różne rodzaje rozkazów w procesorze?

W procesorze rozkazy można podzielić na kilka kluczowych kategorii, które mają istotne znaczenie dla realizacji obliczeń. Do tych typów należą:

- rozkazy arytmetyczne – takie jak dodawanie i odejmowanie, stanowią podstawę większości działań obliczeniowych, niezbędnych w codziennych operacjach,

- rozkazy logiczne – na przykład AND, OR oraz NOT, umożliwiają przeprowadzanie operacji bitowych, co jest istotne dla przetwarzania informacji oraz podejmowania decyzji w aplikacjach,

- rozkazy sterujące – obejmujące instrukcje skoków i pętli, mają kluczowe znaczenie dla kontroli przepływu programu,

- rozkazy transferu danych – odpowiadają za ładowanie oraz zapisywanie informacji w pamięci, co jest niezbędne do efektywnej komunikacji pomiędzy różnymi elementami systemu.

Każdy typ rozkazu ma swoje specyficzne zastosowanie, a ich współpraca jest ściśle związana z wydajnością procesora. Sposób, w jaki przetwarzane są te instrukcje, jest powiązany z mikroarchitekturą procesora oraz projektowaniem systemów obliczeniowych. Efektywne przydzielanie zadań jednostkom wykonawczym przyczynia się do realizacji skomplikowanych operacji w krótszym czasie, co znacząco podnosi ogólną wydajność systemu.

Co to jest jednostka arytmetyczna i jak działa?

Jednostka arytmetyczna, znana jako ALU (Arithmetic Logic Unit), odgrywa niezwykle istotną rolę w działaniu procesora. Jej głównym zadaniem jest realizacja obliczeń arytmetycznych oraz operacji logicznych. ALU zajmuje się takimi działaniami jak:

- dodawanie,

- odejmowanie,

- mnożenie,

- operacje logiczne, takie jak AND oraz OR.

Jej praca odbywa się wewnątrz struktury procesora, w której znajdują się rejestry. Te ostatnie służą do przechowywania danych oraz wyników obliczeń, co zapewnia ALU błyskawiczny dostęp do niezbędnych informacji, minimalizując potrzebę korzystania z pamięci operacyjnej. W procesorach o architekturze RISC, jednostka arytmetyczna bywa szczególnie zoptymalizowana, co pozwala jej na szybsze przetwarzanie większej liczby instrukcji arytmetycznych. Taka poprawa znacząco podnosi wydajność całego systemu komputerowego.

ALU współdziała z układem sterującym, który zarządza przepływem danych oraz interpretuje polecenia. To połączenie przekłada się na lepszą efektywność obliczeń. Z biegiem lat, jednostki arytmetyczne stają się coraz bardziej zaawansowane, umożliwiając obsługę bardziej złożonych operacji i szybsze przetwarzanie danych. W nowoczesnych procesorach rola ALU jest kluczowa, zwłaszcza w aplikacjach wymagających intensywnych operacji, takich jak gry komputerowe czy oprogramowanie do obliczeń naukowych. Dzięki coraz większym możliwościom, jednostka ta staje się sercem wszelkich działań obliczeniowych, napędzając postęp w różnych dziedzinach technologii.

Jakie są zastosowania koprocesorów arytmetycznych w procesorze?

Koprocesory arytmetyczne, powszechnie znane jako FPU (Floating Point Unit), odgrywają kluczową rolę w architekturze procesorów. Dzięki nim możliwe staje się wykonywanie precyzyjnych operacji na liczbach zmiennoprzecinkowych. Stosowane są przede wszystkim w:

- zastosowaniach naukowych,

- inżynieryjnych,

- graficznych,

- gdzie skomplikowane obliczenia są na porządku dziennym.

FPU znacząco zwiększa szybkość procesów obliczeniowych, co z kolei przyspiesza realizację złożonych zadań. W przeciwieństwie do głównych jednostek arytmetycznych (ALU), koprocesory te są wyspecjalizowane w zadaniach związanych z liczbami zmiennoprzecinkowymi, co pozwala komputerom i urządzeniom mobilnym na obsługę bardziej wymagających aplikacji.

Współczesne procesory są projektowane z coraz większą ilością rdzeni i architekturą wielordzeniową, co stwarza możliwości lepszego wykorzystania koprocesorów arytmetycznych. Na przykład w programach do modelowania 3D oraz w obliczeniach naukowych FPU umożliwia równoległe przetwarzanie danych, co drastycznie skraca czas potrzebny na renderowanie i przeprowadzanie skomplikowanych obliczeń.

Zastosowanie koprocesorów arytmetycznych przyczynia się do znaczącej poprawy wydajności systemów obliczeniowych, umożliwiając wykonanie złożonych zadań w krótszym czasie. Dlatego też są one integralną częścią nowoczesnych architektur komputerowych, które z założenia skupiają się na intensywnych operacjach obliczeniowych.

Jaką rolę odgrywa pamięć podręczna w procesorze?

Pamięć podręczna, często określana jako cache, odgrywa kluczową rolę w wydajności procesora. Znacznie przyspiesza dostęp do często używanych danych, pełniąc funkcję szybkiej pamięci, która gromadzi te informacje i umożliwia natychmiastowy dostęp w porównaniu z pamięcią RAM.

Organizacja pamięci podręcznej ma charakter hierarchiczny, z trzema poziomami:

- L1 – oferuje najszybszy dostęp do danych, co pozwala na przechowywanie kopii ostatnio używanych informacji,

- L2 – działa jako druga warstwa, która wspiera L1,

- L3 – pełni funkcję pamięci podręcznej trzeciego poziomu, która jest wolniejsza, ale pojemniejsza.

Dzięki temu minimalizuje się konieczność komunikacji z wolniejszą pamięcią główną. Kiedy procesor potrzebuje danych do przeprowadzenia obliczeń arytmetycznych, najpierw sprawdza pamięć podręczną, co znacząco zwiększa jego efektywność i pozwala na równoległe wykonywanie wielu zadań.

W architekturze procesora pamięć podręczna nie tylko poprawia wydajność operacyjną, ale również potrafi obniżyć zużycie energii. Dzięki zastosowaniu zaawansowanych algorytmów zarządzania pamięcią, obliczenia odbywają się szybciej, a system jest mniej obciążony.

Nowoczesne procesory charakteryzują się integracją różnych typów pamięci podręcznej, co maksymalizuje ich wydajność. Starannie zaprojektowana pamięć podręczna jest kluczowym elementem każdego efektywnego procesora.

Jakie znaczenie ma częstotliwość taktowania?

Częstotliwość taktowania, wyrażana w gigahercach (GHz), stanowi kluczowy wskaźnik wydajności procesora. Mówi nam o liczbie cykli zegara, które procesor realizuje w ciągu jednej sekundy. Wyższa częstotliwość oznacza, że więcej instrukcji można wykonać w krótszym czasie, co z kolei prowadzi do bardziej płynnego działania aplikacji.

Wydajność urządzenia jest ściśle związana z czasem potrzebnym na zrealizowanie danych rozkazów, który to czas mierzymy liczbą cykli wymaganych do ich wykonania. Nie tylko częstotliwość jest istotna—architektura oraz mikroarchitektura procesora mają na celu nie tylko zwiększenie tej wartości, ale także optymalizację metod realizacji instrukcji, co jest równie istotne.

Dodatkowo, nie możemy zapominać o takich kwestiach jak:

- liczba rdzeni,

- wykorzystanie zaawansowanych technologii, takich jak hyper-threading,

- zarządzanie energią,

- które znacząco wpływają na ogólną wydajność.

Złożoność dzisiejszych procesorów sprawia, że ocena wydajności w kontekście częstotliwości powinna uwzględniać inne technologie oraz aplikacje, które wymagają intensywnej mocy obliczeniowej.

Co to jest hyper-threading i jak wpływa na wydajność?

Hyper-threading to innowacyjna technologia opracowana przez firmę Intel, umożliwiająca jednemu rdzeniowi procesora obsługę dwóch wątków w tym samym czasie. Dzięki temu procesory mogą lepiej wykorzystać dostępne zasoby, co prowadzi do znacznej poprawy wydajności. Jest to szczególnie istotne w przypadku aplikacji wymagających pracy wielowątkowej, takich jak:

- edytory wideo,

- programy do obróbki zdjęć,

- gry komputerowe.

Zastosowanie hyper-threadingu zwiększa przepustowość obliczeniową, gdyż procesor nie musi czekać na zakończenie jednego wątku, eliminując w ten sposób niepotrzebne przestoje. Równoległe wykonywanie zadań pozwala na optymalizację dynamiki przetwarzania. W systemach obsługujących tę technologię, system operacyjny postrzega rdzeń procesora jako dwa wirtualne rdzenie, co otwiera drzwi dla aplikacji do korzystania z większej liczby wątków i przekłada się na wyższą wydajność obliczeń.

Niemniej jednak, nie wszystkie programy potrafią efektywnie wykorzystać hyper-threading. Jego skuteczność maleje w przypadku zadań jedno- lub niskowątkowych. W kontekście architektury procesora, hyper-threading przyczynia się do lepszego rozkładu obciążenia pomiędzy rdzeniami, co jest kluczowe dla maksymalizacji wydajności. Procesory wspierające tę technologię znajdują zastosowanie nie tylko w komputerach stacjonarnych, ale także w serwerach, które muszą przetwarzać ogromne ilości danych w trybie równoległym.

Jakie są główne różnice między procesorami wielordzeniowymi a jednorodnymi?

Procesory jednorodne i wielordzeniowe różnią się fundamentalnie w sposobie realizacji zadań obliczeniowych. W przypadku procesora jednorodnego, który posiada tylko jeden rdzeń, operacje są wykonywane sekwencyjnie, co oznacza, że w danym momencie przetwarzane jest tylko jedno zadanie. Z kolei procesory wielordzeniowe dysponują wieloma rdzeniami, co umożliwia jednoczesne przetwarzanie kilku wątków. Taka architektura znacząco podnosi ich efektywność.

Dzięki efektywnemu podziałowi obliczeń pomiędzy rdzeniami, procesory wielordzeniowe sprawdzają się doskonale w aplikacjach wymagających dużej mocy obliczeniowej, takich jak:

- obróbka wideo,

- modelowanie 3D,

- gry komputerowe.

Przez możliwość obsługi wielu strumieni instrukcji naraz, realizacja zadań jest znacznie szybsza. Dodatkowo, jednostki wykonawcze w wielordzeniowych procesorach są często zoptymalizowane do pracy w trybie równoległym, co przekłada się na większą elastyczność w zarządzaniu różnorodnymi zadaniami. W porównaniu z tym, procesory jednorodne mogą napotykać ograniczenia wydajności, zwłaszcza w przypadku nowoczesnych, bardziej złożonych aplikacji. Dzięki temu, procesory wielordzeniowe znacznie ułatwiają wielozadaniowość oraz lepiej radzą sobie z dużym obciążeniem, co czyni je preferowanym wyborem dla użytkowników poszukujących wysokiej wydajności.

Jak proces technologiczny wpływa na wydajność procesora?

Proces technologiczny mierzony w nanometrach (nm) odgrywa kluczową rolę w efektywności procesorów. Zmniejszenie wymiarów pozwala na miniaturyzację tranzystorów, co z kolei umożliwia ich większe zgromadzenie na chipie. Na przykład, technologia 7 nm znacząco zwiększa liczbę tranzystorów w porównaniu do wcześniejszych rozwiązań, takich jak:

- 14 nm,

- 28 nm.

Taki postęp transformuje wydajność obliczeniową, dając procesorowi zdolność do równoległego przetwarzania większych ilości danych. Mniejsze tranzystory zużywają także mniej energii, co ma istotne znaczenie dla efektywności energetycznej systemów. Zredukowany rozmiar elementów poprawia ich właściwości przewodzące, co prowadzi do szybszych operacji oraz mniejszych strat energii w formie ciepła. W rezultacie, możliwości obliczeniowe oraz wydajność operacyjna rosną, co jest szczególnie istotne w kontekście nowoczesnych aplikacji, które wymagają potężnej mocy obliczeniowej. Technologia produkcji jest ściśle złączona z innymi elementami architektury procesora, takimi jak pamięć podręczna oraz liczba rdzeni. Współczesne procesory, które wykorzystują architekturę wielordzeniową, osiągają jeszcze większą efektywność. Inżynierowie nieustannie pracują nad innowacjami, aby sprostać rosnącym wymaganiom użytkowników oraz dostosowując się do dynamicznego rozwoju oprogramowania.

Jak procesor poprawia swoje właściwości przewodzące?

Aby poprawić wydajność przewodzenia w procesorach, istotną rolę odgrywają materiały o wysokiej przewodności, takie jak:

- miedź,

- aluminium.

To właśnie one są niezbędne w obwodach procesora, umożliwiając efektywne przenoszenie sygnałów elektrycznych pomiędzy tranzystorami. Dzięki tej technologii możliwe jest zapewnienie prawidłowego funkcjonowania urządzeń. Tranzystory, będące kluczowymi elementami tych układów, również zyskują na optymalizacji, co poprawia ich przewodzące właściwości. Nowoczesne metody produkcji, w tym:

- trawienie chemiczne,

- wytwarzanie w skali nano.

Pozwoliły one na stworzenie mniejszych tranzystorów, co skutkuje zwiększoną gęstością oraz efektywnością. Dodatkowo, zastosowanie napromieniowania UV ma istotny wpływ na modyfikację właściwości przewodzących krzemu. Te innowacje są niezwykle ważne, szczególnie w kontekście rosnących oczekiwań dotyczących wydajności i mocy nowoczesnych procesorów, które muszą sprostać wymagającym zadaniom.

Co zyskujemy dzięki zmniejszonym rozmiarom elementów procesora?

Zmniejszanie rozmiarów elementów procesora, takich jak tranzystory, znacząco wpływa na wydajność i efektywność energetyczną układów scalonych. Umożliwia to umieszczanie większej ilości tranzystorów na tej samej powierzchni, co automatycznie podnosi moc obliczeniową procesora. Inżynierowie w branży komputerowej dążą do miniaturyzacji, co skutkuje wprowadzaniem coraz bardziej zaawansowanych funkcji.

Ważnym atutem mniejszych tranzystorów jest:

- niższe zużycie energii,

- lepsze efektywne wykorzystanie energii – ma to kluczowe znaczenie w urządzeniach przenośnych, gdzie długi czas pracy na baterii jest na wagę złota,

- zmniejszone napięcie robocze procesora prowadzi do mniejszego wydzielania ciepła,

- co przekłada się na lepszą stabilność i dłuższą żywotność komponentów.

Nowoczesne procesory o technologii 7 nm zapewniają znacznie lepsze parametry niż starsze wersje, które bazują na technologiach 14 nm czy 28 nm. Dzięki postępom tym ich efektywność obliczeniowa wzrasta, co z kolei pozwala na równoległe przetwarzanie większych ilości danych. Zmiana rozmiarów elementów przyczynia się także do ważnych innowacji w mikroarchitekturze, wspierając coraz bardziej zaawansowane obliczenia, które są niezbędne w dzisiejszych aplikacjach.

Jak przebiega proces produkcji procesora?

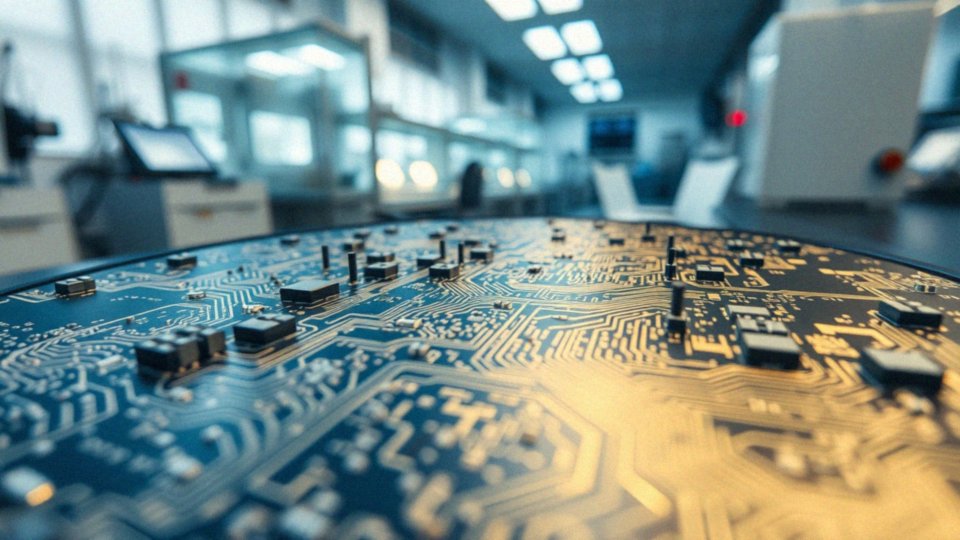

Produkcja procesora zaczyna się od wydobycia piasku kwarcowego, który jest bogatym źródłem krzemu. Po wydobyciu, krzem poddawany jest oczyszczeniu, a następnie przekształca się w monokryształy. Te kryształy są cięte na wafle, które stanowią fundament dla układów scalonych.

Kolejnym etapem jest litografia, podczas której na powierzchni wafli za pomocą promieniowania ultrafioletowego tworzone są precyzyjne wzory. Po zakończeniu litografii następuje proces trawienia chemicznego, który eliminuje nadmiar materiału i kształtuje struktury tranzystorów. Kolejny krok to napromieniowanie wafli jonami, co zmienia ich właściwości, zwiększając przewodnictwo.

Na koniec przeprowadza się testy, aby ocenić jakość i wydajność wafli. Gdy tylko spełnią one wymagania, są przekształcane w gotowe procesory, które po integracji z interfejsem płyty głównej zaczynają ożywać. Warto zwrócić uwagę na to, że cały proces odbywa się na nanoskali, co ma kluczowy wpływ na wydajność procesorów.

Mniejsze komponenty nie tylko umożliwiają wprowadzenie bardziej zaawansowanych funkcji, ale także zwiększają liczbę tranzystorów na chipie. To wszystko w efekcie skutkuje znacznie wyższą mocą obliczeniową. Użyte materiały oraz precyzyjne metody produkcji są niezbędne, aby uzyskać optymalne parametry działania procesora.

Co to jest litografia i dlaczego jest kluczowa w produkcji procesorów?

Litografia odgrywa kluczową rolę w procesie tworzenia procesorów. Polega na precyzyjnym nanoszeniu wzorów na wafle krzemowe z wykorzystaniem promieniowania ultrafioletowego oraz specjalnych masek. To dzięki temu skomplikowanemu procesowi możemy uzyskiwać maleńkie tranzystory i obwody, które są fundamentem nowoczesnych, wydajnych układów scalonych.

Aby rozpocząć, wafle pokrywa się materiałem wrażliwym na światło, a następnie są naświetlane promieniami UV. Obszary, które zostały poddane naświetleniu, są potem trawione, co prowadzi do powstania złożonych wzorów, niezbędnych dla kolejnych etapów produkcji.

Dzięki niezwykłej precyzji litografii istnieje możliwość:

- redukcji wymiarów komponentów,

- zwiększenia gęstości tranzystorów na chipach.

W przypadku technologii o wymiarach 7 nm można zmieścić miliardy tranzystorów, co przekłada się na znaczny wzrost mocy obliczeniowej. Co więcej, mniejsze tranzystory charakteryzują się mniejszym zużyciem energii, co jest kluczowe z perspektywy efektywności energetycznej. Litografia nie tylko wspomaga lepsze zarządzanie ciepłem, ale także przyczynia się do ogólnej wydajności nowoczesnych procesorów oraz ich zaawansowanych możliwości technologicznych.

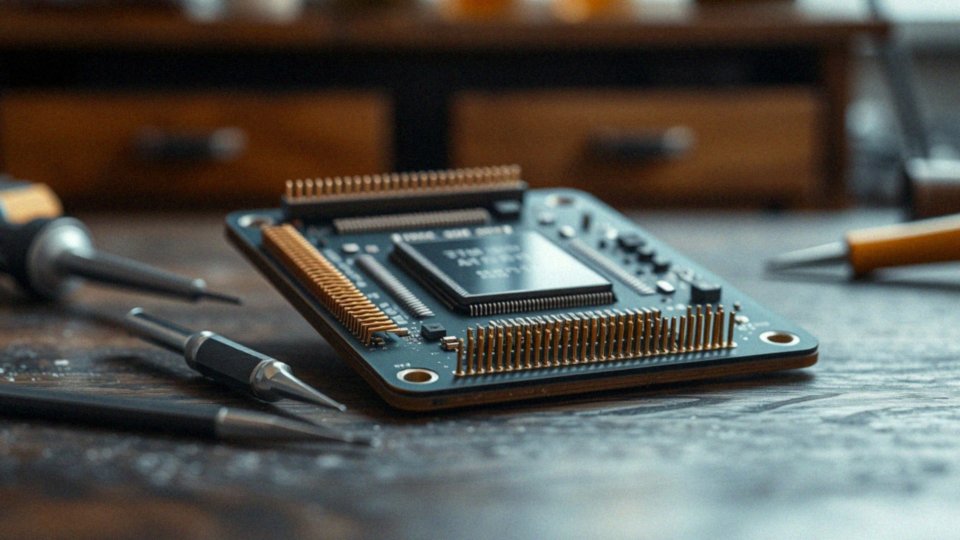

Jakie materiały są używane w budowie procesora?

Materiały odgrywają kluczową rolę w konstrukcji procesorów. Krzem, miedź oraz aluminium to najważniejsze składniki układów scalonych. Monokryształy krzemowe działają jako półprzewodniki, co umożliwia efektywne obliczenia oraz tworzenie złożonych mikroobwodów. Ich funkcjonowanie opiera się na współdziałaniu z różnorodnymi warstwami półprzewodników. Miedź i aluminium są niezwykle istotne dla budowy procesorów, gdyż tworzą obwody łączące różne komponenty, co sprzyja skutecznemu przewodzeniu sygnałów elektrycznych.

Izolatory oraz materiały dielektryczne muszą spełniać wysokie normy, co ma bezpośredni wpływ na bezpieczeństwo i prawidłowe działanie procesorów. Na przykład, postęp technologiczny oraz inwestycje w innowacyjne materiały mają na celu poprawę właściwości przewodzących elementów procesora, co zwiększa ich efektywność i szybkość.

Dodatkowo, nowatorskie metody produkcji, takie jak nanotechnologia, przyczyniają się do rozwijania procesorów o coraz bardziej zaawansowanych funkcjach, a ich rozmiary stają się coraz mniejsze.

Jakie są różnice między architekturą Intel Skylake a AMD Zen 3?

Architektura Intel Skylake i AMD Zen 3 różni się znacząco zarówno pod względem konstrukcji, jak i wydajności. Skylake, która zadebiutowała w 2015 roku, szybko zdobyła uznanie za swoją doskonałą wydajność w grach oraz skuteczne wykorzystanie technologii hyper-threading, co korzystnie wpływa na moc obliczeniową.

Natomiast AMD Zen 3, zaprezentowana w 2020 roku, oferuje istotne ulepszenia, takie jak:

- większa liczba rdzeni,

- lepsza energooszczędność.

Procesory oparte na architekturze Zen 3 są szczególnie efektywne w zadaniach wielowątkowych, jak rendering 3D czy obróbka wideo. Co więcej, wykorzystanie nowoczesnej technologii produkcyjnej 7nm sprawia, że procesory AMD mają wyższą gęstość tranzystorów. Dzięki temu osiągają często lepsze wyniki w benchmarkach wydajności, zwłaszcza w kontekście zastosowań serwerowych oraz zadań wymagających intensywnej mocy obliczeniowej.

Różnice w zużyciu energii są również znaczące. AMD Zen 3 wyróżnia się skutecznym zarządzaniem energią, co wiąże się z niższą temperaturą pracy i mniejszym zużyciem prądu. To z kolei przynosi korzyści nie tylko użytkownikom indywidualnym, ale także przedsiębiorstwom.

Obie architektury mają różne podejścia do wydajności: Skylake jest lepsza w grach, podczas gdy Zen 3 przewodzi w zastosowaniach wymagających wielowątkowości i intensywnych obliczeń. Te różnice umożliwiają użytkownikom dokonanie świadomego wyboru procesora w zależności od ich specyficznych potrzeb i oczekiwań.